Hoy vamos a hablar del contenido duplicado interno y cómo controlarlo en parte con el archivo Robots.txt

El contenido duplicado interno se produce cuando una página o artículo de un blog, aparecen en internet bajo varias url´s diferentes, pero que muestran lo mismo.

Podría ocurrir que alguien haya copiado nuestros posts sin haber puesto un backlink adecuado hacia nuestro sitio. Pero eso no es lo que más nos afecta en este caso. Nos vamos a centrar en el contenido duplicado interno.

En Google webmasters podremos investigar los errores que arroja nuestro sitio web, las url que están dando problemas.. así sabremos dónde atacar.

Hay algunos plugins de WordPress para convertir nuestra web en una versión móvil,que pueden provocar que nuestras url´s se reproduzcan desagradablemente , creando contenido duplicado.

¿El contenido duplicado SEO .. tiene Solución?

De nuevo vamos a ver qué podemos hacer con el archivo robots.txt

El archivo robots.txt nos facilitará la exclusión de cierto tipo de url´s, es decir..

con el robots.txt, le diremos a Google qué paginas o posts puede indexar, y cuáles no

Podemos utilizarlo para bloquear una página web concreta, o un tipo de archivos concretos

También es interesante bloquear ciertos directorios de nuestra web. Por ejemplo, podemos bloquear el directorio de plugins, o un directorio de imágenes privadas…

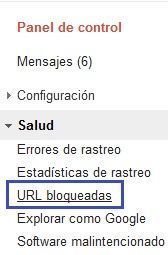

Por supuesto en Google Webmasters (o Search Console desde ya hace un tiempo) nos animan a utilizar este archivo. Iremos a la pestaña Salud, la desplegamos y clickamos sobre URL Bloqueadas

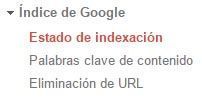

ACTUALIZACIÓN: Ahora las páginas bloqueadas las podemos ver en Indice de Google/estado de Indexación

y ahí marcaremos la pestaña: Páginas bloqueadas por robots

Cuando accedamos a Google Webmasters, veremos el archivo robots.txt por defecto , que pinta tal que así:

User-agent: * Disallow: |

User-Agent: Define el robot, o los robots a los que se aplicarán las reglas que posteriormente creemos.

Disallow: Aquí se pone la URL que queremos bloquear.

Para evitar que los robots de Google accedan a ese contenido duplicado, usaremos Disallow.

Para ilustrarnos adecuadamente, vamos a ver el primer ejemplo. Tenemos un problema, creado por uno de los plugins de conversión móvil. Este plugin resulta que ha creado varias copias de nuestras url´s , acabando todas de esta forma:

DOMINIO/nivel1/?wpmp_switcher=mobile

Pues esto lo solucionaremos con robots.txt

Hemos de decirle a las arañas de Google que no accedan a esas url. Ahora bien , hemos de conocer también 2 parámetros del robots.txt muy útiles:

* Se utiliza para especificar la concordancia con un conjunto de carácteres.

$ Indica que la url acaba con los carácteres que pongamos (concordancia con el final de la url)

Por ejemplo:

1 2 | User-agent: * Disallow: /*.xls$ |

Bloqueará todas las url que acaban con .xls

Esta línea bloqueará concrétamente el acceso a las url que estén construidas: nombre de dominio, seguido de cadena de carácteres, y que acaba con .xls

Así que para solucionar nuestro problema con las url que mostrábamos al principio del post, lo haremos de esta manera:

Disallow: /*?wpmp_switcher=mobile$ |

De esta forma bloquearemos todas las url que acaben con ?wpmp_switcher=mobile

Otro ejemplos:

– Queremos bloquear el directorio “pruebas”

Disallow: /pruebas/ |

– Para bloquear una página concreta :

Disallow: /nombre_archivo.php |

Como podéis ver, el archivo robots.txt puede ayudarnos a controlar esas url´s rebeldes que no dejan de atormentarnos, y el contenido duplicado que generan.

Para más info podéis consultar la ayuda de Google Webmasters para el archivo robots.txt

Buen articulo colega, sin embargo me gustaria añadirte que en blogger por ejemplo lo frecuente es ver:

tema-a-tratar/archive.html

tema-a-tratar/2013_52_23.html

tema-a-tratar/p/242.html

3 urls dinamicas para una misma pagina, lo bueno es con el robots.txt eliminar 2 url para que no se indexen

pro ejemplo

…/archive.html

y

…/p/242.html

saludos!

Muchas gracias por tu aportación! , y gracias por leer El Taller Del Bit!.

Un saludo!

Quisiera hacer una pregunta. Si quiero bloquear una secuencia de caracteres, por ejemplo, todo lo que contenga en numerosas urls los elementos: component/content

¿Lo correcto sería: Disallow: */component/content/* ?

Es así…?

Gracias por la información.

Cami

Pues si utilizas el probador de robots.txt de Google Webmaster podrás comprobar esa regla y otras que quieras probar.

En principio sí que te bloquearía lo que deseas.

También podrías utilizar:

Disallow:*component

Por otro lado no olvides configurar los parámetros en Google Webmasters. Añade component como parámetro y elige la opción:

Ninguna URL (puede impedir el acceso de Googlebot al contenido y anula la configuración de otros parámetros).

Ten en cuenta que si algún otro archivo o url lleva ese parámetro, tampoco será indexada.

Un saludo.